Vídeos gerados pela IA agora são possíveis com GPUs de jogos com apenas 6 GB de VRAM

Lvmin Zhang e GirubEm colaboração com Maneesh Agrawala na Universidade de Stanford, apresentou o Framepack nesta semana. O Framepack oferece uma implementação prática da difusão de vídeo usando o contexto temporal de comprimento fixo para um processamento mais eficiente, permitindo vídeos de maior e maior qualidade. Um modelo de parâmetros de 13 bilhões criado usando a arquitetura Framepack pode gerar um clipe de 60 segundos com apenas 6 GB de memória de vídeo.

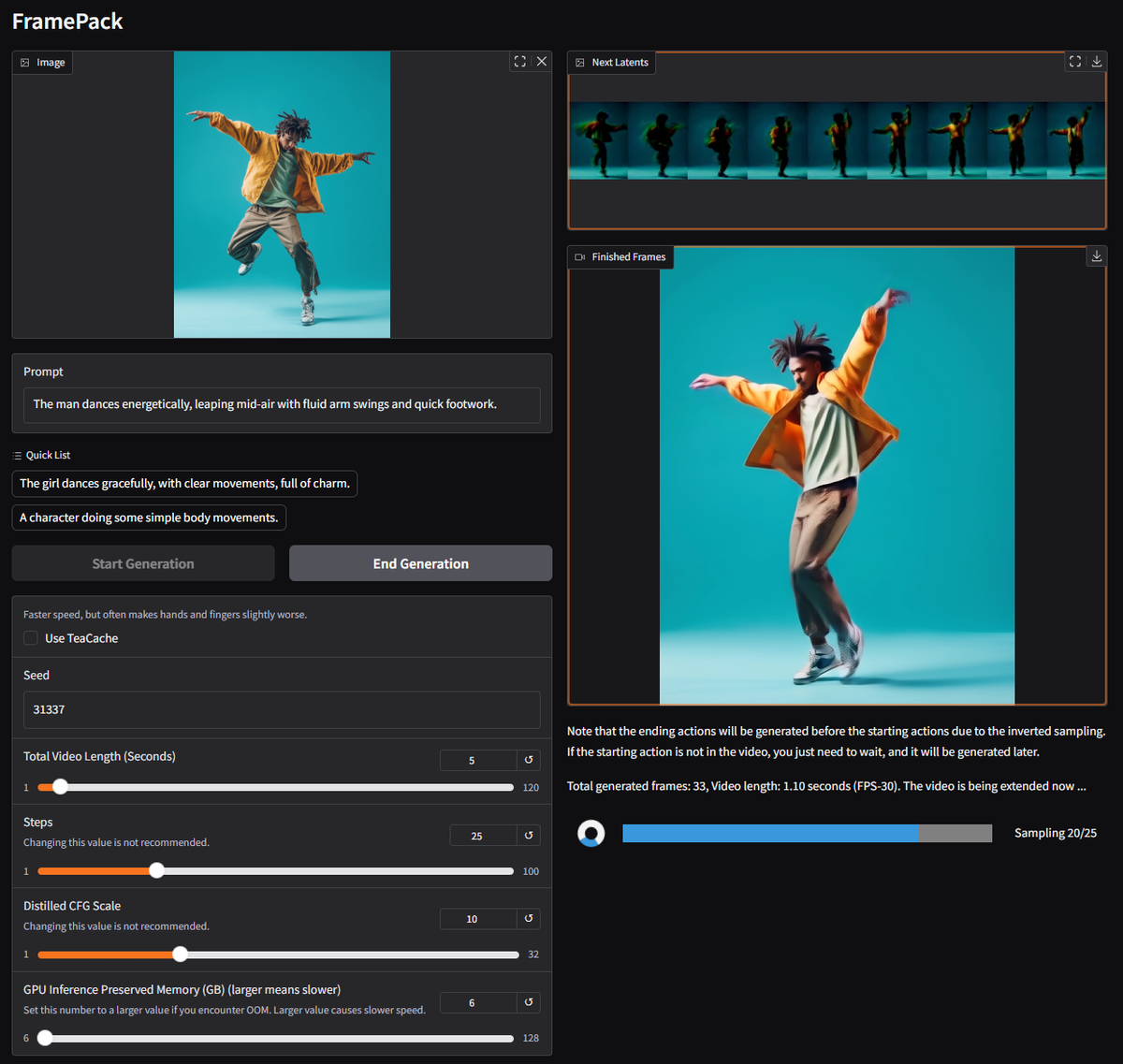

O Framepack é uma arquitetura de rede neural que usa técnicas de otimização de vários estágios para permitir a geração local de vídeo da IA. No momento da redação deste artigo, diz-se que a GUI da Framepack administra um modelo personalizado de Hunyuan sob o capô, embora o artigo de pesquisa menciona que os modelos pré-treinados existentes podem ser ajustados usando o Framepack.

Os modelos de difusão típicos processam dados de quadros barulhentos gerados anteriormente para prever o próximo quadro um pouco menos barulhento. O número de quadros de entrada considerados para cada previsão é chamado de comprimento do contexto temporal, que cresce com o tamanho do vídeo. Os modelos de difusão de vídeo padrão exigem um grande pool de VRAM, sendo 12 GB um ponto de partida comum. Claro, você pode se safar com menos memória, mas isso tem o custo de clipes mais curtos, menor qualidade e tempos de processamento mais longos.

Digite o Framepack: uma nova arquitetura que comprime os quadros de entrada, com base em sua importância, em um comprimento de contexto de tamanho fixo, reduzindo drasticamente a sobrecarga da memória da GPU. Todos os quadros devem ser compactados para convergir em um limite superior desejado para o comprimento do contexto. Os autores descrevem os custos computacionais como semelhantes à difusão de imagem.

Juntamente com as técnicas para mitigar “Drifting”, onde a qualidade se degrada com o comprimento do vídeo, o Framepack oferece uma geração de vídeo mais longa sem compromisso significativo à fidelidade. Como está, o Framepack requer uma GPU da série RTX 30/40/50 com suporte para os formatos de dados FP16 e BF16. O suporte em arquiteturas Turing e mais antigo não foi verificado, sem menção ao hardware da AMD/Intel. O Linux também está entre os sistemas operacionais suportados.

Além do RTX 3050 4GB, a maioria dos GPUs modernos (RTX) atende ou excede os critérios de 6 GB. Em termos de velocidade, um RTX 4090 pode distribuir até 0,6 quadros/segundo (otimizado com teacache), então sua milhagem variará dependendo da sua placa de gráfico. De qualquer forma, cada quadro será exibido após a geração, fornecendo feedback visual imediato.

O modelo empregado provavelmente possui uma tampa de 30 fps, que pode ser limitadora para muitos usuários. Dito isto, em vez de confiar em serviços de terceiros dispendiosos, a Framepack está abrindo caminho para tornar a geração de vídeo da IA mais acessível para o consumidor médio. Mesmo se você não é um criador de conteúdo, essa é uma ferramenta divertida para fazer GIFs, memes e outros enfeites. Eu sei que vou dar uma chance no meu tempo livre.